Hvad er en browserens brugeragent?

Din browser sender sin brugeragent til hvert websted, du opretter forbindelse til. Vi har skrevet om at ændre browsers brugeragent før - men hvad er en brugeragent i alligevel?

En brugeragent er en "streng" - det vil sige en tekstlinje - identificerer browseren og operativsystemet til Webserver. Dette lyder simpelt, men brugeragenter er blevet et rod i tiden.

Grundlæggende

Når din browser forbinder til et websted, indeholder det et brugeragentfelt i sin HTTP-header. Indholdet af brugeragentfeltet varierer fra browser til browser. Hver browser har sin egen, særprægede brugeragent. I det væsentlige er en brugeragent en måde for en browser at sige "Hej, jeg er Mozilla Firefox på Windows" eller "Hej, jeg er Safari på en iPhone" til en webserver.

Webserveren kan bruge dette information til at vise forskellige websider til forskellige webbrowsere og forskellige operativsystemer. For eksempel kan et websted sende mobilsider til mobile browsere, moderne sider til moderne browsere og en meddelelse "Opgrader din browser" til Internet Explorer 6.

Undersøg brugeragenter

F.eks. Er Firefox's brugeragent på Windows 7:

Mozilla / 5.0 (Windows NT 6.1; WOW64; rv: 12.0) Gecko / 20100101 Firefox / 12.0

Denne brugeragent fortæller webserveren en hel del: Operativsystemet er Windows 7 NT 6.1), det er en 64-bit version af Windows (WOW64), og browseren selv er Firefox 12.

Lad os nu se på Internet Explorer 9s brugeragent, som er:

Mozilla / 5.0 ; MSIE 9.0; Windows NT 6.1; WOW64; Trident / 5.0)

Brugeragentstrengen identificerer browseren som IE 9 med Trident 5-gengivelsesmotor. Du kan dog se stedet forvirrende - IE identificerer sig selv som Mozilla.

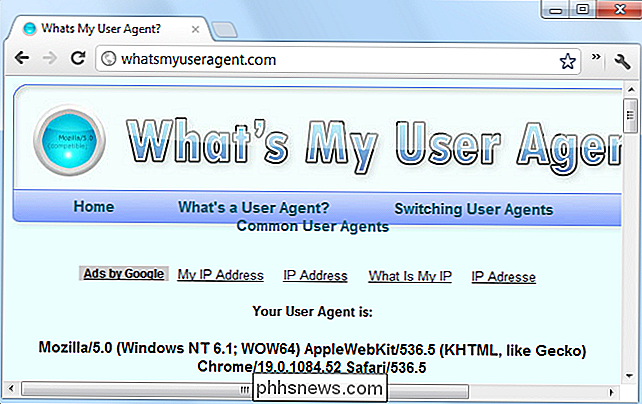

Vi kommer tilbage til det om et øjeblik. Lad os først undersøge Google Chrome's brugeragent også:

Mozilla / 5.0 (Windows NT 6.1; WOW64) AppleWebKit / 536.5 (KHTML, som Gecko) Chrome / 19.0.1084.52 Safari / 536.5

Grunden tykner: Chrome er foregiver at være både Mozilla og Safari. For at forstå hvorfor, skal vi undersøge historien for brugeragenter og browsere.

Brugeragentens strengebud

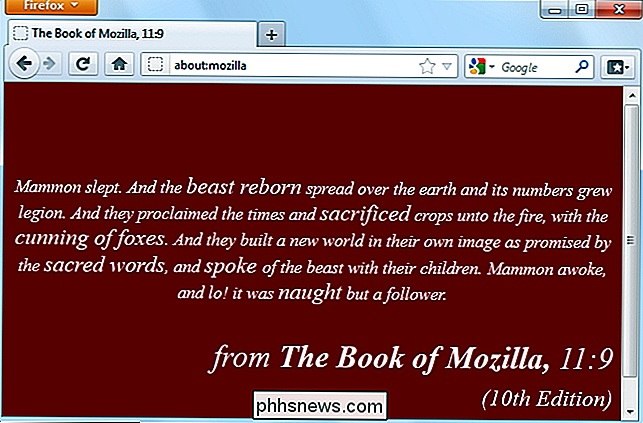

Mosaic var en af de første browsere. Dens bruger agent streng var NCSA_Mosaic / 2.0. Senere kom Mozilla sammen (senere omdøbt til Netscape), og dets brugeragent var Mozilla / 1.0. Mozilla var en mere avanceret browser end Mosaic - det understregede især rammer. Webservere kontrolleres for at se, at brugeragenten indeholdt ordet Mozilla og sendte sider, der indeholder rammer til Mozilla-browsere. Til andre browsere sendte webservere de gamle sider uden rammer.

Til sidst kom Microsofts Internet Explorer sammen, og det understøttede også rammer. IE modtog dog ikke websider med rammer, fordi webservere bare sendte dem til Mozilla-browsere. For at løse dette problem tilføjede Microsoft ordet Mozilla til deres brugeragent og indsatte yderligere oplysninger (ordet "kompatibelt" og en henvisning til IE.) Webservere var glade for at se ordet Mozilla og sendte IE de moderne websider. Andre browsere, der kom senere, gjorde det samme.

Til sidst søgte nogle servere ordet Gecko - Firefox renderingsmotor - og gav Gecko browsere forskellige sider end ældre browsere. KHTML - oprindeligt udviklet til Konquerer på Linuxs KDE-skrivebord - tilføjede ordene "som Gecko", så de ville få de moderne sider designet til Gecko også. WebKit var baseret på KHTML - da den blev udviklet, tilføjede de ordet WebKit og holdt den oprindelige "KHTML, som Gecko" linje for kompatibilitetsformål. På denne måde fortsatte browserudviklere at tilføje ord til deres brugeragenter over tid.

Webservere er ikke rigtig bekymre sig om, hvad den nøjagtige brugeragentstreng er - de kontrollerer bare for at se om den indeholder et bestemt ord.

Bruger

Webservere bruger brugeragenter til en række forskellige formål, herunder:

- Visning af forskellige websider til forskellige webbrowsere. Dette kan bruges til godt - for eksempel at tjene enklere websider til ældre browsere - eller ondt - for eksempel at vise en "Denne webside skal ses i Internet Explorer" -meddelelsen.

- Viser forskellige indhold til forskellige operativsystemer - for eksempel ved at vise en nedtonet side på mobile enheder.

- Indsamling af statistikker, der viser browsere og operativsystemer, som brugerne bruger. Hvis du nogensinde ser browser-markedsandelsstatistikker, er det sådan, de er erhvervet.

Web-crawling-robotter bruger også brugeragenter. For eksempel identificerer Googles webcrawler sig som:

Googlebot / 2.1 (+ //www.google.com/bot.html)

Webservere kan give bots særlige behandling - for eksempel ved at tillade dem igennem obligatoriske registreringsskærme. (Ja, det betyder, at du undertiden kan omgå registreringsskærme ved at indstille din brugeragent til Googlebot.)

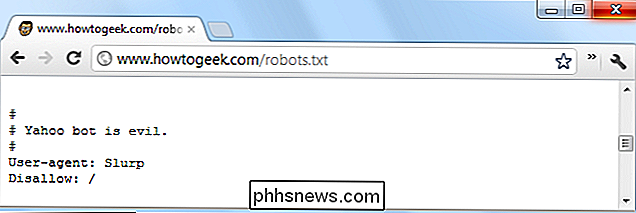

Webservere kan også give ordrer til specifikke bots (eller alle bots) ved hjælp af robots.txt-filen. For eksempel kan en webserver fortælle en bestemt bot at gå væk, eller fortælle en anden bot at kun indeksere bestemte områder af hjemmesiden. I robots.txt-filen identificeres bots af deres brugeragentstrenger.

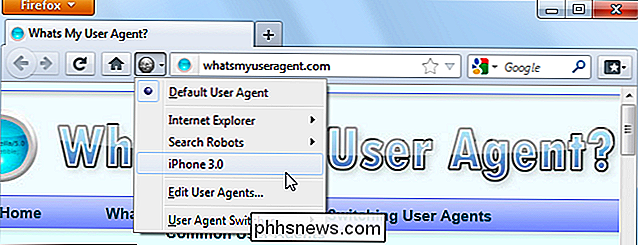

Alle større browsere indeholder måder at indstille brugerdefinerede brugeragenter på, så du kan se, hvilke webservere der sendes til forskellige browsere. Du kan f.eks. Indstille din computers browser til en mobilbrowsers brugeragentstreng, og du får vist de mobile versioner af websider på dit skrivebord.

Sådan søger du efter bestemte faner i Safari på iOS 10

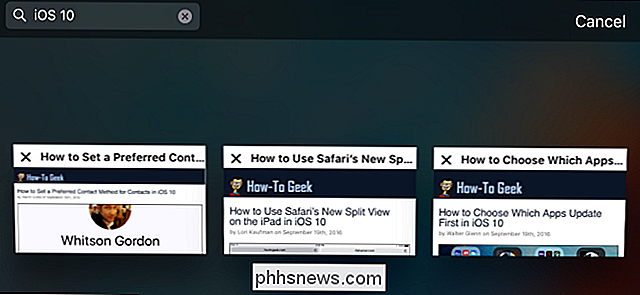

Med Apple iOS 10 kan du endelig få et ubegrænset antal faner åbent i Safari (grænsen i iOS 9 var 36 faner) . Med så mange faner har du brug for ekstra tricks som at kunne lukke alle faner på én gang. Og nu lader Safari dig også søge efter bestemte faner efter titel. Sådan gør du. Hvis du vil søge i dine åbne Safari-faner, skal du dreje din enhed til landskabsvisning.

Hvad er App Nap? Skal det sænke ned i min Mac Apps?

App Nap, føjet til macOS tilbage i 2013, er ikke en funktion, der lavede overskrifter. Så det er ingen skam at indrømme, tre år senere, at du stadig har ingen idé om, hvad det gør. For at opsummere: App Nap sætter programmer, du ikke bruger eller ser på at "sove", blokkerer dem fra at bruge systemet ressourcer, især CPU'en, indtil du fokuserer på dem igen.